Title

题目

Dual-modality visual feature flow for medical report generation

双模态视觉特征流用于医学报告生成

01

文献速递介绍

医疗报告生成是一项新兴的跨模态文本生成任务。分类任务(曾 X 等人,2020 年;纳伊登科斯卡等人,2022 年;李等人,2023 年;)(Bu 等人,2024 年),其旨在提炼所包含的病理信息在医学图像转化为文字诊断报告的过程中。在医学诊断中,医学影像及其对应的报告能够帮助医生临床决策(Chen 等人,2020 年)。然而,撰写医学报告要求放射科医生具备专门的医学知识。并且耗时费力(Yan 等人,2022 年;Xu 等人,)2023 年)。医疗报告生成技术的应用不仅能够减轻工作负担,同时将由人为因素导致的误诊降至最低。因此,医疗报告生成具有诸多因素(秦和宋,2022 年)。逐渐吸引了众多相关领域研究人员的关注。医学与人工智能。许多基于深度学习的方法已被提出以实现医学报告的自动生成(张等人,2023 年;杨等人,)2023 年)。主流方法首先涉及对医学图像进行预训练使用骨干网络(即卷积神经网络/视觉变换器)提取不同年龄阶段的特征,然后对齐这些特征。从不同的网格特征中提取带有报告文本嵌入的内容以跨模态的方式构建网络结构(Zhang 等人,2023 年)。因此,提取医学图像特征以及对不同模态的数据进行对齐是生成高质量报告的关键要素。这些方法有取得了进展,但仍存在三个挑战:1)缺乏关注关键信息,如病变位置和器官详情;2)不足关于内部边缘信息之间相互作用的思考在特征提取期间;3)跨模态数据对齐方面的局限性。具体而言,如图 1 所示,医学图像包含大量显著的诸如器官和病变大小之类的信息。传统的网格特征是无法准确识别病变的位置和大小。区域级需要将这些特征作为补充信息纳入其中。提高医学图像处理方法的表征能力(杨等人,2021 年;田岛等人,2023 年)。此外,大多数现有的医疗报告生成方法从固定区域提取特征在医学图像上确定网格点并解读医学信息以全局方式包含在图像中(黄等人,2023 年;曹)(et al., 2023)。然而,这些方法会导致器官位置出现偏差。

在不同的网格内,且网格之间缺乏互动导致内部边缘信息的丢失。此外,在联合学习时视觉特征和报告文本嵌入,不同类型的特征对应报告中的不同内容。网格特征往往侧重于在全局文本信息方面,而区域特征则更侧重于因此,一个恰当的匹配方法能够提供本地信息。引导模型学习局部和全局的表达能力。受这些观点启发,我们提出了一种新颖的深度双模态融合不同视觉特征的视觉特征流(DMVF)方法以增强对医学影像的全面理解进行多角度的视觉-文本跨模态学习以增强医学报告的表达能力。这项工作的主要贡献在于可以总结如下:我们提出了一种用于医学报告的双模态视觉特征流。该生成器提取并对齐多角度医学图像视觉信息通过报告文本嵌入来增强模型推理的功能能力。我们设计了一种区域级特征提取与增强模块在网格级特征之上添加网格线以增强视觉编码效果从全球和局部视角出发,这是在深度医疗领域的首次尝试。报告生成。我们将不同的视觉特征与医疗报告文本嵌入对齐。为了增强模型的文本推理能力,考虑研究不同类型的特征。大量的对比和消融实验表明在性能方面DMVF 超过了最先进的(SOTA)方法。定量和定性的结果。本文其余部分的结构安排如下:第 2 节介绍相关工作和问题。第 3 节提供了详细的描述。DMVF 的深层结构和公式化表述。第 4 节介绍了相关的理论分析。第 5 节展示了实验结果。第 5 节进行了总结与分析,第 6 节给出了结论性意见和未来展望。

Abatract

摘要

Medical report generation, a cross-modal task of generating medical text information, aiming to provide professional descriptions of medical images in clinical language. Despite some methods have made progress, there are still some limitations, including insufficient focus on lesion areas, omission of internal edge features, and difficulty in aligning cross-modal data. To address these issues, we propose Dual-Modality Visual Feature Flow (DMVF) for medical report generation. Firstly, we introduce region-level features based on grid-level features to enhance the method’s ability to identify lesions and key areas. Then, we enhance two types of feature flows based on their attributes to prevent the loss of key information, respectively. Finally, we align visual mappings from different visual feature with report textual embeddings through a feature fusion module to perform cross-modal learning. Extensive experiments conducted on four benchmark datasets demonstrate that our approach outperforms the state-of-the-art methods in both natural language generation and clinical efficacy metrics.

医学报告生成是一项跨模态任务,旨在生成医学文本信息,以临床语言提供医学图像的专业描述。尽管一些方法已取得进展,但仍存在一些局限性,包括对病变区域的关注不足、内部边缘特征的遗漏以及跨模态数据对齐的困难。为了解决这些问题,我们提出了用于医学报告生成的双模态视觉特征流(DMVF)。首先,我们基于网格级特征引入区域级特征,以增强方法识别病变和关键区域的能力。然后,我们根据特征属性增强两种类型的特征流,以防止关键信息的丢失。最后,我们通过特征融合模块对齐来自不同视觉特征的视觉映射与报告文本嵌入,以进行跨模态学习。在四个基准数据集上进行的大量实验表明,我们的方法在自然语言生成和临床效果指标方面均优于最先进的方法。

Method

方法

3.1. Dual-modality visual feature extraction

The method combines grid and region features representing global and local information, respectively. Next, we introduce the different types of visual features sequentially.Grid Features.During the extraction process, the model divides the image into fixed-size grids and extracts the global semantic information. Previous researchers typically used classicalCNNs (e.g., ResNet) for thispurpose. However, these networks make it challenging to capture longterm dependencies in medical images. To enhance the model’sability to capture pathological features within grid features, we introduce SwinTransformer as the feature extractor, which offers high performance with lower computational demands.

3.1 双模态视觉特征提取本方法结合了分别代表全局信息和局部信息的网格特征与区域特征。以下依次介绍不同类型的视觉特征。网格特征:在提取过程中,模型将图像划分为固定大小的网格并提取全局语义信息。以往研究者通常采用经典CNN(如ResNet)实现这一目标。然而,这类网络难以捕捉医学图像中的长程依赖关系。为增强模型从网格特征中捕获病理特征的能力,我们引入计算需求较低且性能优越的SwinTransformer作为特征提取器。

Conclusion

结论

In this paper, we propose an effective medical report generation method named DMVF, which extracts visual features from multiple perspectives and achieves high-quality medical report generation through cross-modal alignment.For the task of medical report generation, most of existing methods mainly involve two steps: first, extracting visual features from medical images, and then aligning these visual features with textual features across modalities. Based on this, we, depart from the diagnostic process of doctors, introduce innovatively region-based feature representations to capture organ lesion information, thereby enhancing the model’s understanding of medical images. Simultaneously, we align visual data flow containing different information features with text embedding, increasing the model’s ability to express medical reports, aiming to comprehensively improve report generation effectiveness from bothimage and text perspectives. Experimental results demonstrate that compared to existing methods, ours exhibits excellent performance by comprehensively analyzing medical images, enhancing the model’s focus on lesion areas and key organs, and generating realistic and reliable medical reports.In future work, we aim to enhance interpretability through theoretical analysis, improve fairness towards data distribution biases, and enhancescalability through the introduction of different modality features.

在本论文中,我们提出了一种名为DMVF的有效医疗报告生成方法,该方法从多视角提取视觉特征,并通过跨模态对齐实现高质量医疗报告生成。针对医疗报告生成任务,现有方法主要包含两个步骤:首先从医学图像中提取视觉特征,随后将这些视觉特征与跨模态的文本特征对齐。基于此,我们创新性地从医生的诊断过程出发,引入基于区域的特征表示以捕捉器官病变信息,从而增强模型对医学图像的理解。同时,我们将包含不同信息特征的视觉数据流与文本嵌入进行对齐,增强模型对医疗报告的表达能力,旨在从图像和文本双重角度全面提升报告生成效果。实验结果表明,相较于现有方法,我们的方法通过综合分析医学图像、增强模型对病灶区域和关键器官的关注度,能够生成真实可靠的医疗报告,展现出优异性能。在未来的工作中,我们计划通过理论分析增强模型可解释性,提升对数据分布偏差的公平性,并通过引入不同模态特征增强扩展性。

Figure

图

Fig. 1. A case study on organs and lesions in medical images, with important organs and lesions marked in green and red in the image and report, respectively

图。1.一份关于医学影像中器官和病变的案例研究,其中重要的器官和病变分别在图像和报告中以绿色和红色标注。

Fig. 2. The framework of the proposed DMVF mainly consists of dual-modality visual feature extraction, feature flow enhancement module, and cross-model feature fusion module. Firstly, Faster R-CNN and Swin Transformer are utilized to extract grid andregion features from the original medical images, respectively. Then, enhance them based on their different feature attributes. Finally, align visual and textualembeddings using a cross-modal feature fusion encoder. Best viewed in color.

图2. 所提出的DMVF框架主要由双模态视觉特征提取、特征流增强模块和跨模态特征融合模块构成。首先,利用Faster R-CNN和Swin Transformer分别从原始医学图像中提取网格特征和区域特征。随后,根据其不同的特征属性进行增强。最后,通过跨模态特征融合编码器对齐视觉与文本嵌入特征。最佳效果为彩色显示。

Fig. 3. Comparisons among the reports generation by ‘R2Gen’, ‘R2RL’, and ‘Ours’ conducted on the chest X-ray and CT image datasets. Green/red highlights indicate correct/incorrect sentences, respectively, and underlines represent abnormal information.

图3. 在胸部X光和CT影像数据集上由‘R2Gen’、‘R2RL’及‘本方法’生成的报告对比。绿色/红色高亮分别表示正确/错误句子,下划线代表异常信息。

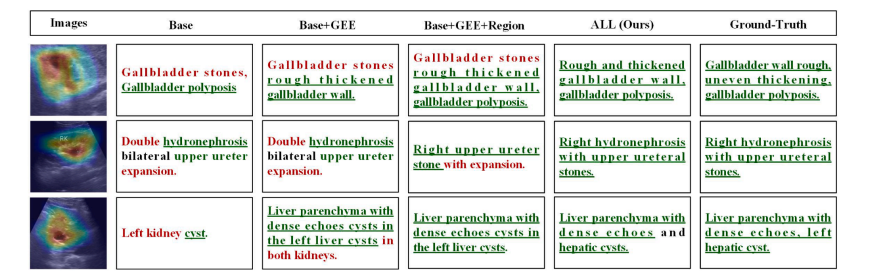

Fig. 4. Comparisons among the reports generation by ‘R2Gen’, ‘CMN’, ‘R2RL’ and ‘Ours’ on the ultrasound image dataset.

图4. 在超声影像数据集上由‘R2Gen’、‘CMN’、‘R2RL’及‘本方法’生成的报告对比。绿色/红色高亮分别表示正确/错误句子,下划线代表异常信息。

Fig. 5. Qualitative analysis of different componment conducted on the chest X-ray and CT image datasets.

图5 胸部X光与CT图像数据集上不同组件的定性分析

Fig. 6. Qualitative analysis of different componment conducted on the ultrasound image dataset.

图6. 在超声影像数据集上对不同组件的定性分析。

Table

表

Table 1 Comparison on four datasets. denotes the results obtained by reproduced based on the publicly codes. The best and second-best results are marked in bold and underlined, respectively.

表1 四个数据集上的对比。表示基于公开代码复现获得的结果。最佳和第二佳结果分别以粗体和下划线标出。

Table 2 Clinical Efficacy metrics on IU X-Ray and MIMIC-CXR datasets with Precision, Recall, F1-score.

表2 IU X-Ray和MIMIC-CXR数据集上基于精确度、召回率与F1分数的临床疗效指标

Table 3 Ablation study on four benchmark datasets. The best and second results are marked in bold and underline, respectively.

表3 四个基准数据集上的消融实验。最佳和次优结果分别以加粗和下划线标出。

Table 4 Performance of different alignment approaches

表4 不同对齐方法的性能表现

Table 5 Comparison of Parameter and Efficiency. ↑ and ↓ represent the higher the better and the lower the better, respectively.

表5 参数与效率对比。↑和↓分别表示数值越高越好和数值越低越好。